利用视觉引导机器人执行太空任务 – NASA

教育、研究与科学 | 机器人技术 | 3D 视觉 | 匹配-Matching

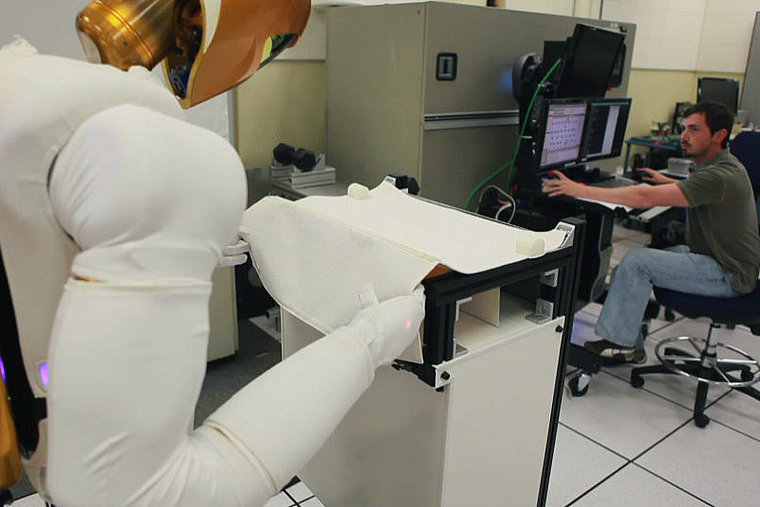

为了支持宇航员在国际空间站 (ISS) 开展工作,NASA(华盛顿特区)、通用汽车(密歇根州底特律)和 Oceaneering Space Systems(德克萨斯州休斯顿) 正在合作开发一款名为 R2 的人形机器人。R2 机器人在外形和比例上与真人宇航员无二,只是缺少下半身,其身体与一个固定支架相连。这款机器人旨在为进行舱外活动 (EVA) 的宇航员提供协助,由于配备了大量触觉、力、位置、测距和视觉传感器,因此具备物体识别和操纵等诸多功能。

Oceaneering Space Systems 机器人和自动化团队 Robonaut ISS 应用负责人 Brian Hargrave 表示:“我们希望 R2 能够协助执行多项 ISS 任务,其中包括感知和操纵用于盛放一系列工具的纺织品容器,而这是最具挑战性的任务之一。要想取出工具,必须先找到盒子,然后把盒子打开,取出工具,最后关闭盒子。尽管底座已固定,但织物制成的盖子在零重力条件下通常会不停晃动,而且不知在什么时候就会自行合上。因此,要想顺利完成这项任务,除了需要利用盖子状态估计和抓取规划技术外,还必须同时加入计算机视觉和运动规划方法。

在 3D 飞行时间成像仪和一对立体相机的共同作用下,R2 机器人能够为系统提供深度信息和可视化立体图像。其中,MESA Imaging(瑞士苏黎世)的 Swiss Ranger SR4000 飞行时间相机能够生成 3D 位置信息,Allied Vision(德国施塔特罗达)的两台 Prosilica GC2450 GigEVision 相机能够捕捉彩色立体图像。MVTec Software(德国慕尼黑)的 HALCON 9.0 图像处理软件则能够将各类传感器数据集成到单一开发环境中。”

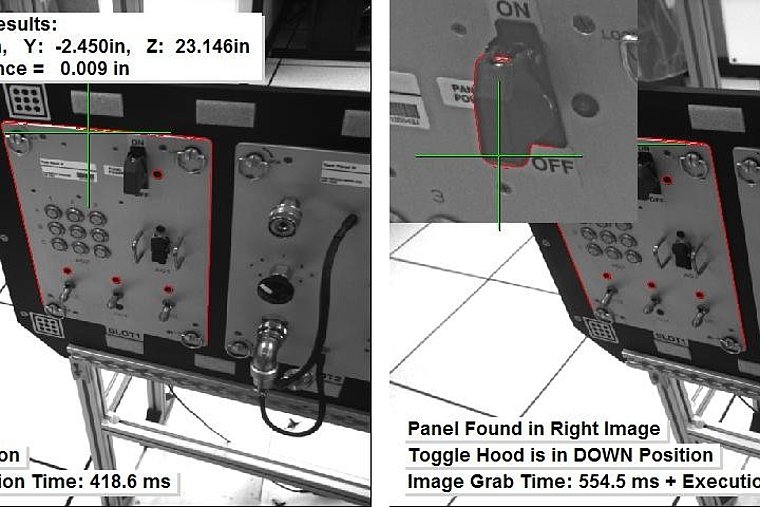

为了实现稳定可靠的物体自动识别和姿态估计,需要精准分析来自立体和 TOF 传感器的各种复杂模式。ToF 传感器能够有效区分背景与机器人前方的物体,从而忽略掉相机图像中的背景像素。由于系统仅凭借一台与机器人相连的笔记本电脑来控制机器人的定制触觉力和位置传感器并执行物体识别,因而处理能力非常有限。因此,系统首先会根据颜色、像素强度或纹理以及所应用的模式识别技术对图像中的感兴趣区域 (ROI) 进行分割。Hargrave 介绍道:“在小 ROI 中搜索模式比在大图像中搜索模式要快得多。简单的模式识别将用于寻找 ROI,而复杂的模式识别将会用于 ROI 内部。”

Hargrave 及其同事选择利用 HALCON 9.0 中的纹理分割功能来锁定纺织品盒子的位置。由于盒盖紧固件由闩锁和索环组成,因此可借助基于形状的匹配技术在立体图像中找出这些元素。当盖子打开,在零重力状态下浮动不定时,可以利用同样的技术搜索处于任何方向的紧固件。要计算盖子紧固件的姿态,必须找出紧固件组件在每个立体图像中的位置。通过将 HALCON 内置分类技术与立体对校准和 TOF 位置信息结合使用,可以实现模式识别功能。系统由此能够生成一条可行轨迹,从而指导机器人完成合拢盖子以打开盒子的动作。

作者:Lutz Kreutzer 博士

感谢Vision Systems Design提供本文。产品/商标的所有产品名称、商标和图片版权均属于其持有者。保留所有权利。